Macbox enterprice kopie

Vom Raumschiff Enterprise zur

!

! ! Keksschachtel

Wie ich die Entwicklung der Informationstechnik in der Zeit von 1940 bis 2010 erlebte

"Hältst Du die Liebe für den stärksten Affekt?" fragte er.

"Weißt Du einen stärkeren?"

"Ja, das Interesse."

Thomas Mann in "Dr. Faustus"

Ein Gespräch zwischen Dr. Zeitblohm und Adrian Leverkühn:

1. Anstelle eines Vorwortes

Im Jahre 1940, ich war 12 Jahre alt, lag ich mit Kopfhörern im Bett und lauschte der Sendung des Reichssenders Leipzig, die ich mit meinem Detektor empfing. Heute, 70 Jahre später, liege ich im Bett, habe die Ohrhörer mit dem iPhone verbunden und empfange den Fernsehsender Arte mittels EyeTV über Wireless LAN und die oben genannte „Keksschachtel", wie ich liebevoll meinen Mac mini nenne.

Zwischen diesen beiden Ereignissen liegt eine rasante technisch wissenschaftliche Entwicklung, die ich versucht habe zu begreifen und in meinem Umfeld und damit in der Praxis anzuwenden. Versuche den jeweiligen Wissensstand auf meinem Tätigkeitsgebiet anzuwenden wurde mir oft als technische Spinnerei ausgelegt. Mitarbeiter und Vorgesetzte, die mich kannten, akzeptierten aber allmählich die Realität, die hinter meinen Vorstellungen steckte.

Den Namen „Raumschiff Enterprise" im Titel, benutze ich zur Charakterisierung des

Begriffs „Schöpferische Fantasie", die von Albert Einstein über das schlichte Wissen

gestellt wurde:

„

Imagination is more important than knowledge. For knowledge is limited to all we

now know and understand, while imagination embraces the entire world and all

there ever will be to know and understand."

Denn, so sagt Einstein, Kenntnisse sind begrenzt auf das was wir wissen, während Fantasie die ganze Welt umfasst und al es, was wir jemals wissen und verstehen können.

Der Philosoph und Computerexperte Alan N. Shapiro hält Star Trek für einen großen Textder westlichen Kultur. In den nachstehenden Ausführungen möchte ich Elemente der Kultserie „Raumschiff Enterprise" wie das Beamen (entmaterialisieren und wieder zusammensetzen (materialisieren)) und den Warpantrieb als im Moment unmöglich erscheinende physikalische Gesetze nicht als die in meiner Umwelt zu verwirklichenden Ziele ansprechen.

Hingegen erscheinen mir aber Gedanken der Vernetzung von Computern und der künstlichen Intelligenz real. Das im Raumschiff übliche Bildfernsprechen (Anruf auf den Schirm!) hat mich z.B. dazu veranlasst, auf meinem Computer Skype zu implementieren und regelmäßig mit Freunden und Familienmitgliedern mittels Bildtelefon zu kommunizieren. ScFi-Filme bei denen auf den Bildschirmen lediglich Lissajou-Figuren zu sehen sind, schalte ich sofort aus.

In einem Rechner (Multitasking System) laufen viele Prozesse im Hintergrund ab während man im Vordergrund z.B. Dateien erzeugt oder durchsieht. Im Leben und in der Gesellschaft werden im Hintergrund Entwicklungen durchgeführt, Erfindungen gemacht oder Schlachten geschlagen, während der Betrachter einfach seiner Arbeit nachgeht. Im folgenden Text will ich demnach in den mit „Hintergrund" bezeichneten Abschnitten Ereignisse beschreiben, von denen ich unter Umständen erst Jahre später erfahren habe, die aber für die technisch wissenschaftliche Entwicklung von größter Bedeutung waren.

2.Hintergrund um 1940

2.1 Das PCM-Prinzip

Seit der Erfindung des Telefons durch Philipp Reis und Graham Bell bestand das Problem der Übertragung über große Entfernungen darin, dass das Nutzsignal, wie in Bild1 dargestellt, stets von Störungen überlagert wurde.

Bild 1: Überlagerung einer Sprachschwingung durch Störung (rot)

Mit der notwendigen Verstärkung des Signals wurde also gleichzeitig das Rauschen mit verstärkt. Es gab keine Möglichkeit das zu verhindern. Bis zum Jahre 1938, als der französische Wissenschafter Reves das PCM-Prinzip erfand. (Erstaunlicherweise kann man in Wikipedia nichts über Reves lesen)

Bild 2: PCM-Prinzip

Das Prinzip ist so genial wie einfach. Die Sprachschwingungen werden mit Impulsen abgetastet. Die Länge der Impulse wird gemessen und als 8 Bit lange Binärzahl nacheinander als Bit-Strom zur Gegenstelle übertragen. Jedoch:Die Maße der zur Verfügung stehenden Röhren, Übertrager, Spulen. Widerstände und Kondensatoren lagen 1938 in der Größenordnung von Zentimetern. Die Brettschaltung eines 24 Kanal PCM-Geräts, das aus Studiengründen Ende der 40iger Jahre in Ost-Berlin aufgebaut worden war, besaß die Fläche eines Wohnzimmers und erzeugte die Wärme eines Ofens.

Die Realisierung des PCM-Prinzips war damit der Zeit nach der Erfindung des Transistors und der integrierten Schaltkreise vorbehalten.

2.2 Der Digitalrechner

Ab 1939 tobte der 2. Weltkrieg. Es war kein Raum für Nachrichten aus Wissenschaft und Technik, noch dazu wenn sie ggf. militärisch von Interesse sein konnte. Konrad Zuse (1910-1995) war Statiker bei den Henschel Flugzeugwerken und musste immer viele

lange Formeln berechnen. Er sagte von

sich scherzhaft: „Da ich zu faul zum

Rechnen war, überlegte ich, wie man

eine Maschine bauen kann, die einem

Menschen lange Rechenoperationen

abnimmt.

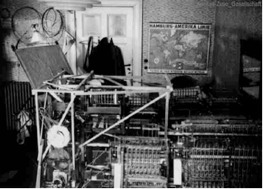

Der Z 1 war ein mechanisches

Rechenwerk. K. Zuse hatte ihn

1936-1938 im Wohnzimmer seiner

Eltern aufgebaut (Bild 4). Sein Vater half

ihm beim Aussägen der Metallteile mit

der Laubsäge. Ein Mangel des Z1 war,

dass sich die mechanischen

Schaltglieder im Betrieb verhakten.

Um den Rechner Z1 zu bauen, gab

Zuse 1936 seine Stelle bei den

Henschel Flugzeugwerken auf und

arbeitete nur noch zu Hause.

Der Z1 enthält schon die wichtigsten

Elemente eines Computers, war jedoch

wegen mechanischer Probleme

unzuverlässig.

Bild 3: Konrad Zuse (nach Wikipedia) !

Der Z1 wurde im Zweiten Weltkrieg

zerstört. Man baute ihn in den 1960er

Jahren nach. Er kann im Technikmuseum in Berlin besichtigt werden

Dem mit der Rechentechnik nicht vertrauten Leser muss nun zunächst die Frage beantwortet werden, wie eine Maschine rechnen kann:- Es müssen Zahlen gewählt werden, die maschinengerecht darstellbar sind, bestehend aus „ja – nein" (0, 1) Schritten.

- Es muss eine Eingabevorrichtung existieren, mit der man der Maschine etwas mitteilen kann.

- Für die Zahlen müssen Speicherplätze existieren, damit sich die Maschine etwas merken

Bild 4: Der Z1 im Wohnzimmer der Familie Zuse (nach Wikipedia)

- Für die Grundrechenarten müssen feste Bausteine vorhanden sein. (plus, minus, mal, geteilt durch)- Für die zu lösende Aufgabe muss eine genaue Vorschrift ( ein Programm) existieren (eingegeben werden).

- Das Rechenergebnis muss die Maschine ausgeben können.

Das Zahlensystem, das für diesen Zweck geeignet erscheint, ist das von Gottfried Wilhelm Leibnitz (1646 - 1716) entwickelte binäre Zahlensystem.

Das binäre Zahlensystem kann über Potenzen mit der Basis 2 im Vergleich mit dem Dezimalsystem (Potenzen mit der Basis 10) erklärt werden. Es genügt aber auch die phänomenologische Darstellung durch Werte von 0 und 1 wie in Bild 5 gezeigt.

Bild 5: Beispiele für Binärzahlen

Den dezimalen Wert einer Binärzahl zu erkennen, erfordert einige Übung. Man erlernt das am Besten durch Trainieren mit Hilfe eines kleinen Glühlampenfeldes (Bild 6), das durch Schalter bedient wird.

Bild 6: Beispiel für ein Glühlampenfeld zur Anzeige von Binärzahlen

In Zeile 1 brennen die Lampen die für 20 = 1, 22 = 4, 26 = 64 stehen, angezeigt ist 69.!

In Zeile 2 brennen die Lampen die für 23 = 8, 25 = 32 stehen, angezeigt ist 40.!

Das Rechnen mit Binärzahlen erfolgt mit Hilfe besonderer Regeln. Im Bild 7 ist zunächst eine Addition dargestellt, bei der wir intuitiv die Technik der Rechnung mit Dezimalzahlen verwenden.

Bild 7: Addition zweier Binärzahlen

An Bild 7 erkennt man, dass es bei der Verknüpfung von Binärzahlen eigene Regeln gibt.

Z.B. wird bei der „Addition" zweier Binärzahlen eine Operation verwendet, die man im

Gegensatz zum Begriff Addition (bei Dezimalzahlen) als exklusives Oder oder auch als

Antivalenz bezeichnet. Es gilt:

Die Operation mit der der Übertrag gebildet wird, ist das logische Und.

Eine weitere Verknüpfung ist das logische Oder. Hierbei ist das Ergebnis 1 (wahr), wenn

wenigstens einer der beiden Eingangswerte 1 (wahr) ist.

Schließlich gibt es noch die Negation. Der Ausgangswert ist dabei das Gegenteil des Eingangswertes. Die Negation einer Zahl kann mit einem Querstrich über derselben dargestellt werden.

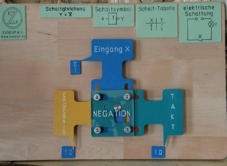

Wie Zuse die Elementaroperationen „Nicht" mechanisch ausgeführt hat, soll an Bild 8a und b dargestellt werden.

Bild 8: a) Eingang = 0, Takt liegt nicht an, b) Eingang = 0, Takt: Ausgang =1

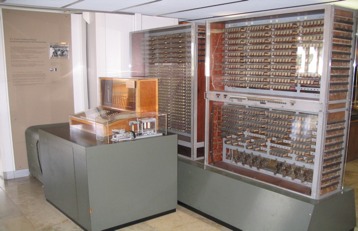

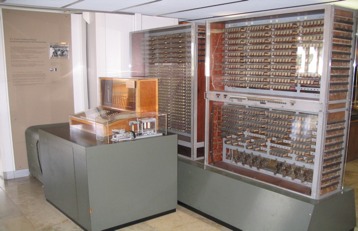

In seinem Z3 hat Zuse die logischen Schaltungen mit Relais aufgebaut. Wie das erfolgt, soll später erklärt werden. Der Z3 war der erste funktionsfähige, programmgesteuerte Rechner der Welt. Am 12.5.1941 wurde er zum ersten Mal erfolgreich öffentlich vorgeführt. Der Rechner wog 1000 kg und verbrauchte 4 KW Strom.

Den Nachbau des Z3 kann man im Deutschen Museum in München besichtigen (Bild 9)

Bild 9: Nachbau des Z3 im Deutschen Museum in München.

Ab 1942 entwickelt Zuse die Z4, eine Synthese aus Z1 und Z3. In dieser Zeit fielen Bomben auf Berlin, Z1 und Z3 versanken unter Schutt und Trümmern, in einem Keller arbeitete Zuse mit etwa 20 Leuten verbissen an der Z4 weiter.In den letzten Tagen vor dem Fall Berlins gelang es Zuse, die Maschine auf einen Eisenbahnwagen zu verladen und sich mit seiner Frau und Mitarbeitern nach Hopferau bei Füssen zu flüchten. Von 1945 bis 49 hielt sich Zuse wirtschaftlich mit Bildermalen über Wasser und entwickelte nebenbei die Programmiersprache Plankalkül. Im Jahre 1949 konnte Zuse endlich den Z4 für fünf Jahre an das neugegründete Institut für Angewandte Mathematik der Eidgenössischen Technischen Hochschule ETH in Zürich vermieten.

Mit dem Mietgeld von 30 000 Franken baute Zuse eine KG auf, die in den Fünfzigerjahren in Bad Hersfeld zu einem Unternehmen mit tausend Beschäftigten wuchs. 1964 wurde die Firma von Brown Boveri & Cie. übernommen, später von Siemens.

Der interessierte Leser möge weitere Details bei Google im Internet nachlesen.

3. Vordergrund ab 1940

Ich selbst gehe seit 1939 auf die Oberschule, baue in der Freizeit Radios mit

Elektronenröhren und werde mit der Klasse 1944 als Luftwaffenhelfer eingezogen.

Ende 1944 melde ich mich zu einem Techniker-Lehrgang, der im Westerwald bei Daaden an

der Sieg stattfindet. Da sich die Westfront dem Rhein nähert, wird der Lehrgang in die

Luftnachrichtenkaserne München Freimann verlegt. Mit noch zwei Kameraden setze ich

mich Anfang April nach Hause (Gera, Thüringen) ab, um mich kurz vor Eintreffen der

Amerikaner zu einem Panzerjagdkommando des Volkssturms zu melden.

Der Krieg endet am 8.Mai. Unsere Einheit wird aufgelöst.

Wieder zu Hause, setzte ich nicht meine Schulausbildung fort, sondern trete eine Lehre als

Elektroinstallateur bei der Firma Petzold und Hänsel in Gera an. Da ich Radios bauen kann,

setzt mich der Meister zunächst in der Rundfunkwerkstatt ein, wo ich auch mithelfen muss

Kinoanlagen zu betreuen und zu reparieren.

Bei meinem Studium von Fachliteratur auf dem Gebiet der Hochfrequenztechnik bemerke

ich einen Mangel an mathematischen Kenntnissen. Ich gehe regelmäßig zu einem

Schulfreund und arbeite nach, was dieser im Mathematikunterricht gelernt hat. Meine

hauptsächliche Belehrung besteht jedoch in der handwerklichen Arbeit, im Aneignen von

Fertigkeiten, die ich später noch manchmal gut einsetzten kann.

Oberstudienrat Kordmann, ein alter Lehrer, der nicht Mitglied der NSDAP war, ist nun

Direktor der Oberschule. Er gestattet mir nach Abschluss der Gesellenprüfung im Frühjahr

1948 wieder in die 11. Klasse der Schule zu gehen und bei Versetzung im Sommer in die

Abiturklasse einzusteigen. Das Schuljahr 1949 beende ich mit dem Abitur.

Meine Bewerbung an der Technischen Hochschule Dresden wird trotz guter Abiturnoten

abgewiesen. Zu viele Heimkehrer bewerben sich um Fortsetzung ihres Studiums.

Als Alternative komme ich einer Werbung der Volkspolizei nach und werde im Juli 1949

nach Prenzlau eingezogen. Beim Sortieren der Ankömmlinge in solche, die der VP-

Bereitschaft zugeteilt werden und solche, die zum Fliegerhorst gehen, greife ich in mein

Schicksal ein. Ich teile mich, als ehemaliger Luftwaffenhelfer die Luftwaffenbauten liebend

der Mannschaft zu, die zum Fliegerhorst (und damit zur VP-Schule) gehen.

In der VP-Schule nehme ich nur wenige Tage an der Grundausbildung teil. Es wird jemand

gesucht, der in der Lage ist eine Kinoanlage einzubauen. Natürlich ist so etwas interessanter

als im Gelände herumzukriechen, daher melde ich mich. Damit habe ich wieder eine

Weiche gestellt, da ich jetzt als Kulturleiter (Klubleiter) gezählt werde.

Neben dem Einbau der Kinoanlage überwache ich die Installation einer elektroakustischen

Anlage, organisiere Ausstellungen und schreibe Theaterstücke.

Nach Ende des einjährigen Lehrgangs werde ich zum Polizeimeister befördert und als

Klubleiter in die VP-Bereitschaft meiner Heimatstadt Gera versetzt.

Dort führe ich aushilfsweise Elektrotechnikunterricht in der Nachrichtenabteilung (S2) durch.

Als Polizeimeister, der an einer Schule ausgebildet wurde, werde ich zum Unterkommisar

befördert. Ein Vertreter des Chefs Nachrichten (der Hauptverwaltung Ausbildung des MdI)

wird auf mich aufmerksam und veranlasst meine Versetzung in die Verwaltung Nachrichten

nach Berlin.

Jetzt bin ich endlich da, wo ich immer hin wollte, bei den Nachrichtentruppen. Im Jahre

1952 nehme ich ein Fernstudium am Institut für Hochfrequenztechnik und Elektronenröhren

der TH Dresden auf.

Die nächste Weichenstellung ergibt sich aus dem Umstand, dass ich im Fragebogen die

Existenz meines Schwagers nicht angegeben habe, der in Westberlin an der TU studiert.

Ich werde 1953 als Fachlehrer Nachrichten an die Panzerschule in Erfurt und kurz darauf als

Fachlehrer Elektrotechnik an die Nachrichten-(Funker-)Schule in Pirna versetzt.

Von Pirna aus kann ich regelmäßig zum Studium (zur Konsultation) nach Dresden fahren.

Das Elektrotechnikpraktikum an der TH animiert mich auch an der Offiziersschule

umfangreiche Praktika für Elektrotechnik und Instandsetzung einzuführen.

Als die Nachrichtenschule (Funk) Pirna 1955 mit der Nachrichtenschule (Draht) Halle in Döbeln zur Nachrichtenschule der NVA vereinigt wird, werde ich als Lehrstuhlleiter für

Instandsetzung von Nachrichtengeräten übernommen.

4. Hintergrund ab 1945

Am 23. Dezember 1947 wird bei einer internen Demonstration bei den Bell Laboratories erstmals ein Spitzentransistor präsentiert. Die an der Erfindung des Transistors (1948) beteiligten William B. Shockley, John Bardeen und Walter Brattain erhielten dafür 1956 den Nobelpreis für Physik. Die Bauelemente für Fernmeldegerät und Rechentechnik wurden dadurch wesentlich kleiner (Bild 10)

Bild 10: Beispiele für Transistoren

Mit diesem neuen Bauelement ausgerüstet kommt 1955 „TRADIC" (Transistor Digital

Computer) der erste voll transistorisierte Computer auf den Markt. Er bestand aus ca.

10.000 Germanium Dioden und ca. 700-800 Transistoren. Seine Leistungsaufnahme

betrug nur ca. 100 Watt.

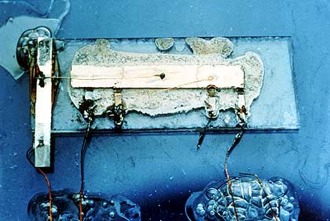

Eine technische Revolution ist die Erfindung des integrierten Schaltkreises durch Jack Kilby. Das Stück Halbleiter, auf dem er zwei Transistoren und Bauelemente mit Golddrähten verbindet, hat die Größe einer Büroklammer. Kilby demonstriert seine Erfindung am 12. September 1958 im Labor bei Texas Instruments.

Bild 11: der erste integrierte Schaltkreis

Der erste integrierte Schaltkreis ohne Verdrahtung wird von Robert Noyce im Juli 1959 zum Patent angemeldet. Damit beginnt das Zeitalter der hochintegrierten Schaltkreise, zuerst mit zwei, drei, zehn, dann 100, dann 1000, heute Millionen bis zu Milliarden von Bauelementen auf einem CHIP.

Nicht nur in der Technologie werden Fortschritte erzielt. Der amerikanische Wissenschaftler Norbert Wiener veröffentlicht 1948 Das Buch „Cybernetics or Control and Communication in the Animal and the Machine" Die Deutsche Ausgabe lautet „Kybernetik. Regelung und Nachrichtenübertragung im Lebewesen und in der Maschine". Im Internet findet man die Definition von Paulik 2005, (S. 519):„Kybernetik ist die Wissenschaft, die sich mit den Gesetzmäßigkeiten der Steuerung, Regelung und Rückkopplung der Informationsübertragung und Verarbeitung in Maschinen, Organismen und Gemeinschaften beschäftigt sowie die Theorie und Technik der Informationsverarbeitungssysteme untersucht" Nach anfänglicher Ablehnung dieses Fachgebietes im Sozialistischen Lager wird dieser Wissenschaftszweig in der DDR zunehmend als theoretische Grundlage für eine Produktivitätssteigerung in der Wissenschaft, in der Lehre und in der Produktion gesehen.

5. Vordergrund ab 1955

Als Stellvertreter des Schulleiters für technische Ausbildung gelingt es mir durch die breite

Einführung von Praktika und durch ein hohes Niveau des technischen Unterrichts an der

Nachrichtenschule der NVA in Döbeln die Anerkennung der renommierten Ingenieurschulen

in Leipzig und Mittweida zu erringen.

Mit dem von mir entwickelten Lehrplan ist es möglich, an der Nachrichtenschule der NVA zu

staatlich anerkannter Ausbildung von Technikern und später Ingenieuren überzugehen.

Im Jahr 1960 beende ich meine Ausbildung zum Diplom Ingenieur mit einer Arbeit über ein

neuartiges Höchstfrequenzsiebentor. In der den theoretischen Grundlagen zugrunde

liegenden Literatur finde ich einen Hinweis, dass eine Reihe von Ergebnissen mit einem

Computer berechnet worden war. Ein Hinweis, der die Anwendung dieser damaligen

Riesenmaschinen in meine gedankliche Nähe rückte.

5.1 Logische Schaltkreise und Modellrechner

Auf der Weimartagung der Kammer der Technik 1961 hielt Dr. Fey einen Vortrag über den

Hamming-Code. Das Prinzip dieser Codierung besteht darin, einer zu übertragenden

Meldung Redundanz hinzuzufügen. Sollen z.B. Telegramme der Länge 4 Bit übertragen

werden, so besteht die Redundanz aus drei zusätzlichen Bit, die der Nachricht nach einem

bestimmten Schema hinzugefügt werden. Wird nun bei der Übertragung eines der 7 Bits

gestört, d.h. eine 1 in 0 oder eine 0 in 1 verwandelt, so lässt sich ein Korrektor berechnen,

der angibt, an welcher Stelle der Fehler aufgetreten ist.

Der Vortrag elektrisierte mich. In meiner Dienststelle fand ich ein Lager mit alten Klein- und

Telegraphenrelais. Diese eignen sich sehr gut für den Aufbau logischer Schaltungen (siehe

Bild 12). Mit diesen Relais baute ich logische Schaltungen auf, die ich zu einem Hamming

Codierer zusammenbaute.

Bild 12: Prinzipschaltbild einer Und-Schaltung im Zustand 1 and 1 = 1

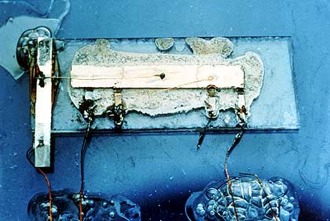

In unserer Nachrichtenwerkstatt diente ein ausgezeichneter Mechaniker. Dieser half mir das

Konzept eines Kybernetikbaukastens zu verwirklichen. Der Baukasten bestand aus

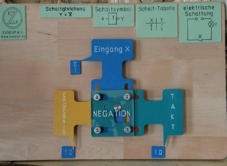

einer großen Pertinaxplatte mit Fassungen und Buchsen. Darauf konnte man ein Sortiment

von UND-, ODER-, NICHT- Gattern sowie ANTIVALENZ-Schaltungen stecken und zu

komplexeren Bausteinen, z.B. Volladdern zusammenschalten.

Der Baukasten wurde im Unterricht der Offiziersschüler benutzt, um logische Schaltungen in

der Rechen- und Signalisierungstechnik zu erklären. Siehe Bild 13.

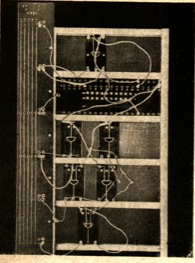

Auch eine Rechenmaschine wurde mit Relais

aufgebaut. Mit der Maschine konnte der größte

gemeinsame Teiler zweier Zahlen bestimmt werden

(Bild 14). Die logischen Schaltungen und der

Arbeitsspeicher wurden dabei durch die

Telegraphenrelais rechts und links der Metallplatte

gebildet. Links unten ist das Glühlampenfeld für die

Ausgabe zu sehen. Über den Lochstreifensender

(im Vordergrund) wurde das Programm eingegeben.

Der Automat hatte zwar kein Zusesches Format,

repräsentierte aber die Komponenten einer

Anfang 1958 wurde an unserer Schule ein junger

Physiklehrer eingestellt. Er hieß Klaus Karl, war ein

guter Pädagoge, fachlich versiert und

wissenschaftlichen Visionen aufgeschlossen. Zur

Qualifikation auf elektrotechnischem Gebiet führte

er an der Ingenieurschule Mittweida ein

Fernstudium durch.

Bild 13: Kybernetikbaukasten, Aufbau einer Antivalenz

Als Ingenieurarbeit entwarf und baute er

1962 das Modell eines elektronischen

Digitalrechners auf Transistorbasis.

Es handelte sich um eine programmgesteuerte Einadress-Serienmaschine mit Flip-Flop-

Speicher für Zahlen und Befehle. Mit dem Gerät konnten sechsziffrige Binärzahlen addiert,

subtrahiert und dividiert werden.

Das war der Beginn unserer Arbeit an

der Schule mit der

Digitalrechentechnik.

Die in der DDR 1955 fertiggestellte

OPREMA bestand aus etwa 17.000

Relais, wurde zur Berechnung von

Linsen eingesetzt und stand für uns an

der Schule in sehr weiter Ferne.

Auch der 1960 auf der Frühjahrsmesse

vorgestellte ZRA1 war eine Maschine

für Rechenzentren von Forschungs-

Bild 14: Modellrechenautomat auf Relaisbasis

Bild 15: Modell eines Elektronischen Digitalrechners auf Transistorbasis

Seit Erscheinen des Buches „Kybernetik, Regelung und Nachrichtenübertragung im

Lebewesen und in der Maschine" von Norbert Wiener im Jahre 1948 war es auf vielen

Fachgebieten in der DDR üblich nach Analogien zur und Anwendungen für die Kybernetik

zu suchen. Oberst Dr. Raulien vom Institut für Mechanisierung und Automatisierung der

Truppenführung schrieb das Buch „Kybernetik im Militärwesen", und wir an der

Nachrichtenschule entzündeten unsere Fantasie daran die Prinzipien der Kybernetik im

Unterricht einzusetzen.

In der Zeitschrift „Mathematik und Physik in der Schule" 10 (1963) Hefte 2 und 3 erschien

ein Artikel von L. N. Landa mit dem Titel „Kybernetik und Unterrichtstheorie".

Nach Landa besteht ein Mangel des Unterrichts gegenwärtig darin, dass er als ein Prozess mit

schlecht funktionierender Rückkopplung verläuft.

Eine Möglichkeit eine solche Maschine zu gestalten, zeigt die von mir aufgebaute Apparatur

Bild 16 : Audiovisuelle Unterrichtsmaschine

Auf ein Tonband wurde ein Kurzvortrag mit eingestreuten Fragen aufgenommen. Bestandteil

des Vortrags sind Lichtbilder. Der Lernende drückte bei jeder Frage eine Antworttaste. Das

Gerät zeigte an, ob die Antwort richtig oder falsch war. Die Antwort musste aus zehn

möglichen ausgewählt werden. Bei falscher Antwort nahm das Gerät die Richtigstellung vor.

Eine solche Anlage ist zum Selbststudium ohne Weiteres geeignet.

Der Aufwand ist aber beträchtlich. Sollen mehrere Schüler eine solche Anlage gleichzeitig

benutzen, muss die Klasse in kleine Kabinen unterteilt werden, in denen die Schüler mit

Kopfhörern sitzen. Zu solchen Überlegungen kam es aber nicht mehr, da die

Nachrichtenschule 1963 mit den Schulen anderer Waffengattungen zur Offiziersschule der

Landstreitkräfte in Löbau Zittau zusammengelegt wurde.

5.3 Die Fehlermatrix

Die Arbeiten von Landa hatten für den Unterricht an der Nachrichtenschule noch eine

weitere Konsequenz. Landa wandte den Begriff des „Erkennungsalgorithmus" u. a. auf das

Erkennen einfacher Satztypen an, indem er empfahl, die Suche nach deren entscheidenden

Merkmalen (Subjekt, Prädikat usw.) schrittweise nach einem algorithmischen Schema zu

vollziehen. Warum sollte ein solches Vorgehen nicht auch beim Erkennen spezieller Typen

elektronischer Bauelemente (z. B. Elektronenröhren) oder sogar von Fehlertypen an einem

Nachrichtengerät funktionieren? Bei der Suche nach entsprechenden Fehlererkennungs-

oder Fehlersuchalgorithmen hatte mein Kollege Klaus Karl die Idee, die häufigsten Fehler

nacheinander künstlich „einzubauen" und das jeweils daraus folgende Verhalten des Geräts

messtechnisch zu erfassen. Dabei wird eine Tabelle entsprechend Bild 17 angelegt.

Im Kopf der Tabelle werden die Bestandteile eines Gerätes, Baugruppen oder Bauelemente

eingesetzt. Danach sind Messungen (oder auch Prüfungen) festzulegen, die mit M1 bis Mn

bezeichnet werden.

Der Buchstabe im Kreuzungspunkt von Spalte und Zeile gibt an, ob ein Fehler Fn das

Ergebnis der Messung Mj beeinflusst (J) oder nicht beeinflusst (N). Der Wert w(Fi) gibt an wie

groß die Wahrscheinlichkeit ist, dass bei defektem Gerät gerade dieser Fehler auftritt.

Bild 17: Zusammenhang zwischen Fehler und Messwert

Es leuchtet ein, dass zur Unterscheidung der Fehler sich alle Spalten des Schemas

voneinander unterscheiden müssen.

Es erscheint ebenfalls logisch, dass die Unbestimmtheit dafür, welcher Fehler aufgetreten ist,

ein Maximum besitzt, wenn alle Fehler mit der gleichen Wahrscheinlichkeit auftreten.

Bei ungleicher Wahrscheinlichkeit ist zweckmäßig diejenigen Messungen als erste

auszuführen, die die Fehler mit der größten Wahrscheinlichkeit aufdecken.

Interessenten an diesem Thema seien an den Artikel;

J. Göller und K. Karl: Die Optimierung der Fehlersuche an elektronischen Einrichtungen mit

Hilfe der Informationstheorie. Nachrichtentechnik 15 (1965) H.12 S.455-461, verwiesen.

Bei der Verlegung der Nachrichtenschule der NVA 1963 nach Zittau verließ Klaus Karl

unsere Lehreinrichtung und wechselte zum Deutschen Pädagogischen Zentralinstitut in

Berlin, wo er 1969 zu Fragen des Programmierten Unterrichts promovierte.

Dr. Karl arbeitete seit 1973 am Forschungs- und Rechenzentrum der Akademie der

Pädagogischen Wissenschaften der DDR in Dresden, u. a. an der Erforschung quantitativer

Zusammenhänge im Leistungsverhalten von Schülern im Mathematikunterricht.

Das sind die Mühen der Ebene bei der Verfolgung von Visionen wie sie die Kybernetik für

den Unterricht hervorbrachte.

6. Hintergrund ab 1960

In der Rechentechnik gab es drei verschiedene Entwicklungsrichtungen.

Der an der TU Dresden (1963) entwickelte D4a war mit 200 Transistoren bestückt, dieRechengeschwindigkeit lag bei 2000 Grundoperationen/Sekunde.

Zur internen Datenablage kam ein Trommelspeicher zum Einsatz, der eine Kapazität von4000 Zeichen (33 Bit Wortlänge) hatte. Die Dateneingabe erfolgte über die Bedientastenoder Lochband, die Ausgabe über einen Streifendrucker.

Der Cellatron C8206 (Bild 18) war eine Schreibtischbauform des D4a (ab 1967).

Bild 18: Cellatron C8205

Im Gegensatz dazu standen die schwergewichtigen Großrechner. In der DDR stand ab

1967 der sowjetische Rechner

BESM-6 (1967) zur Verfügung. Er verarbeitete 1 Million Befehle in der Sekunde bei einer Taktfrequenz von 9 MHz. Er bestand aus 60,000 Transistoren und 170,000 Dioden. Die Programme wurden in Lochkarten gestanzt und über spezielle Leser eingegeben. Ergebnisse wurden ausgedruckt.

Die BESM-6 war der Prototyp der Maschinen wie auch die amerikanischen IBM-Maschinen für Stapelverarbeitung (Batch-Jobs).

Bild 19: Mainframe BESM-6 !

Die Verarbeitung von Batch-Jobs

war lange Zeit eine Domäne

von Mainframes. Ein BESM-6 stand im Institut für Hochenergiephysik der Akademie der Wissenschaften in Zeuthen (sozusagen vor unserer Haustür)

6.3 Multiuser-Systeme

Ein Betriebssystem ist die Verwendung (den Betrieb) eines ermöglicht. Es verwaltet Speicher, Ein- und Ausgabegeräte und

steuert die Ausführung von Die ersten Rechner besaßen kein

Betriebssystem. Z.B. wurde die OPREMA

über Stecktafeln programmiert. Mit der

Einführung der Modellreihe System 360 von

IBM führte IBM 1964 das Betriebssystem

OS/360 ein. Es war das erste

Betriebssystem, das

modellreihenübergreifend eingesetzt wurde.

Bei der Firma Digital Equipment Corporation

(DEC) wurden zu Beginn der 60iger Jahre

Kleinrechner gebaut, die sie

Programmierbare Datenprozessoren

nannten. (PDP-1 bis PDP-16).

Auf einem PDP-7 (Bild 18) entwickelten Ken

Thompson (im Bild 19 li.) und Dennis Ritchie

(im Bild 19 re.) um 1968 das Betriebssystem

Bild 20 : Der Rechner PDP7 der Fa.DEC UNIX. UNIX ist ein Multiuser System.

Es gestattet, dass gleichzeitig mehrere Nutzer auf den Rechner zugreifen. Das geschieht durch Timesharing. Den Benutzern werden nacheinander Zeitintervalle zur Arbeit zugeteilt. Dieser Betrieb wird auch Multitasking genannt.

Das Multiusersystem UNIX wurde Anfang der 70iger Jahre auf Rechner vom Typ PDP-11 portiert und 1975 an die Universitäten verschenkt. Dieser Schachzug war sehr gut durchdacht. An den Universitäten entwickelten Lehrkräfte und Studenten viele Programme, die UNIX immer attraktiver machten.

UNIX ist in der höherenProgrammiersprache C geschrieben.

Damit kann auf jedem Computer, aufdem ein C-Compiler läuft,

UNIX implementiert werden.

Bild 21: Ken Thompson (li.) und Dennis Ritchie r.) !

Besonders die Universität von Berkely förderte die Weiterentwicklung von UNIX.

6.4 Paketdatenübertragung

Telefonieren kann man schon seit 100 Jahren. Am Anfang hat man zu Beginn eines Telefongesprächs das Fräulein vom Amt angerufen und gebeten, mit einem Partner verbunden zu werden. Später wurde zu Beginn des Telefonats die Nummer des Partners gewählt. Die Verbindung erfolgte dann automatisch durch eine Fernsprechvermittlung. Mit einer Fernschreibmaschine kann man seit 80 Jahren Schriftstücke elektrisch übertragen. Das Fernschreiben erfolgt ebenfalls über Wählverbindungen. Mit dem Aufkommen der Rechentechnik entstand der Wunsch Rechner über größere Entfernungen miteinander zu koppeln. Das war natürlich prinzipiell über Fernschreibleitungen möglich, aber die Fernschreibgeschwindigkeit war viel zu niedrig, gemessen an der Arbeitsgeschwindigkeit der Elektronenrechner. Da entwickelten (unabhängig von einander) Paul Baran 1960 in den USA und Donald Watts Davies 1965 in England ein Verfahren, das sie Paketdatenübertragung nannten. Da auf einer Lochkarte, die zur Programm- und Dateneingabe in den Rechner dient, 80 Zeichen pro Zeile geschrieben wurden (Löcher für 1 und „Kein-Loch" für 0 ), bestanden die Datenpakete am Anfang aus Blöcken von 80 Zeichen 0 oder 1. Die Übertragungsgeschwindigkeit war zunächst auf 48000 Bit in der Sekunde begrenzt. Der Datenblock besaß einen Kopf, der den Namen des Absenders und die Adresse des Empfängers enthielt.

Bild 22: Datenpaket mit Adresse, Absender und 80 Zeichen Information.

Damit war es möglich, über die gleiche Leitung Datenpakete von verschiedenen Quellen an unterschiedliche Rechner zu senden. In einer Paketvermittlung wird von jedem

ankommenden Paket die Adresse gelesen, wonach das Datenpaket in eine Leitung geschickt wird, die schließlich zum Zielrechner führt.

6.5 Die Vernetzung von Computern stand nun auf der Tagesordnung.

Im Verteidigungsministerium der USA gab es eine Abteilung die hieß ARPA (Advanced Research Projekts Agency) Agentur für wissenschaftlich bedeutsame Forschungsprojekte. Unter anderem gab die ARPA den Universitäten Geld für den Ankauf von (in den 60er Jahren sehr teuren) Rechenanlagen, wenn sie für die militärische Forschung arbeiteten. Viele Universitäten bewarben sich um einen Computer, aber soviel Geld, alle Universitäten auszustatten, hatte die ARPA nicht.

Ein Mitarbeiter der ARPA hieß Bob Taylor. Der ärgerte sich zusätzlich darüber, dass in seinem Büro Verbindungen zu drei Großrechnern (an drei Universitäten) bestanden, wobei jede Verbindung mit einem anderen Gerät (Computerterminal) abgeschlossen war. Er hatte die Idee ein landesweites einheitliches Computernetzwerk zu schaffen. Er fand die Unterstützung von J.C.R. Licklider, einem Wissenschaftler des MIT (Massachusetts

Institute of Technology),

der zusammen mit Taylor 1967 das erste Papier zum Thema Internet verfasste. Das ARPAnet, das sie gemeinsam mit einer kleinen Gruppe von Wissenschaftlern und Ingenieuren entwickelten, wurde später zur Grundlage für das heutige Internet. Im Jahre 1969 vergab die ARPA den

Auftrag für den Bau der

Bild 23: Kernzelle des ARPANET !

Datenvermittlung (des

IMP = Interface Message

Prozessor) an die Firma Bolt Beranek and Newman. Der IMP war der wichtigste Bestandteil des zukünftigen Netzwerkes. Obwohl selbst große Firmen wie AT&T und IBM abgelehnt hatten, sie hielten das Projekt für nicht realisierbar, nahm "Bolt Beranek und Newman" (BBN) an. Ein halbes Dutzend Ingenieure, die sich selbst als die "IMP-Guys" bezeichneten, arbeiteten nun rund um die Uhr und schafften es tatsächlich, den IMP (auf der Grundlage eines Minicomputers 516 von Honeywell) in der vorgegebenen Zeit zu bauen. Neun Monate später konnte der erste IMP an der University of California Los Angeles (UCLA),, installiert werden. Ein landesweites Netzwerk, genannt ARPAnet, wurde ab jetzt ständig weiterentwickelt.

7. Vordergrund ab 1964

Mit der Fusion der Offiziersschulen der Waffengattungen der Landstreitkräfte in Zittau wurde

zwar ein Rationalisierungseffekt erzielt, aber mein schöpferischer Spielraum für

pädagogische und wissenschaftliche Arbeit wurde enger. Als Stellvertreter des

Fachrichtungsleiters Nachrichten musste ich Genehmigungen einholen, wo ich in Döbeln,

als Stellvertreter des Leiters für die technische Ausbildung freie Hand hatte.

Der Versuch an der TH-Dresden auf dem ZRA1 praktische Beispiele für die Fehlermatrix zu

programmieren verlief unbefriedigend, da der ZRA1 nur für Stapelbetrieb vorgesehen war

und bei Änderung der technischen Parameter neue Lochkarten gestanzt werden mussten.

Die Berufung zum Leiter der Erprobungsstelle für Nachrichtengerät (Nachrichten

Erprobungsstelle, NES) der NVA in Niederlehme, im Jahr 1965, durch den Chef Nachrichten

Generalmajor Reymann nahm ich daher gerne an.

In das zweite Jahr meiner Tätigkeit als Leiter der NES (1967) fiel der 10. Jahrestag des

Bestehens dieser Einrichtung. Ich schlug dem Chef Nachrichten vor, aus Anlass dieses

Jubiläums einen wissenschaftlichen Tag durchzuführen, bei dem Vorträge über

Perspektivthemen gehalten und eine Ausstellung technischer Geräte gezeigt werden sollte,

die durch die NES betreut wurden.

In meinen Vortrag, der natürlich vom Chef Nachrichten zu bestätigen war, baute ich alles ein,

was ich der Führung an Neuem mitteilen wollte. Dem Chef Nachrichten Generalmajor

Reymann war es gelungen, den Chef des Hauptstabes Generaloberst Keßler zu dieser

Veranstaltung einzuladen und mitzubringen.

Der Chef des Hauptstabes zeigte sich sehr interessiert und verfolgte sowohl meine

Ausführungen als auch die Ausstellung sehr genau.

7.1 Uns steht der erste Kleinrechner zur Verfügung

Nach der Veranstaltung lud GM Reymann den hohen Gast zu einem kleinen Imbiss und

einem Gespräch in mein Dienstzimmer ein. Auf dem Weg dorthin ging der Generaloberst in

meiner Begleitung und stellte viele Fragen, aus denen ich bemerkte, dass er die gesamte

Veranstaltung sehr aufmerksam verfolgt hatte. So erkundigte er sich sehr genau, wozu ich

den Kleinrechner Cellatron C8206 (Bild 18), um den ich in meinem Vortrag gebeten hatte,

einsetzen wolle. Meine Antwort, das Gerät für technische Analysen verwenden zu wollen

schien ihn zu überzeugen, und so wurde das Gerät ein halbes Jahr später geliefert.

Eine der ersten Anwendungen des Kleinrechners bestand in der automatisierten Auswertung

der Nachrichtenlage, die im Gerätesatz P 249 einer sowjetischen Nachrichtenzentrale

generiert wurde. Der genannte Gerätesatz enthielt ein Gerät, das die Zustandsdaten aller

Übertragungsgeräte auf einer Fernschreibmaschine (Streifenschreiber) aufzeichnete. Dieses

Protokoll diente als eine Art Logbuch, an dem man nachträglich die Funktion oder

Nichtfunktion der einzelnen Verbindungen nachweisen konnte. Wir ließen diese Protokoll

auf einen Lochstreifensender ausgeben und speisten es in den C8206 ein, der daraufhin eine

übersichtliche Liste der Kanäle und ihres Zustandes über der Zeit enthielt.

Es sollte noch ein paar Jahre dauern, bis dieser Prozess mit Hilfe eines Mikrorechners online

durchgeführt werden konnte.

7.2 Verbindungen zum Institut für Nachrichtentechnik

Die Lage der NES in Niederlehme bei Königs Wusterhausen machte es möglich, bequem

Verbindungen mit Instituten und Industrie, sowie Hochschulen in Berlin anzuknüpfen und zu

pflegen. Einer meiner ersten Besuche galt dem Institut für Nachrichtentechnik, dessen neuer

Direktor Dr.-Ing. Peter Fey war, den ich noch von der TH Dresden kannte und dessen Vortrag

über den Hamming-Code mich auf Probleme der Fehlerkorrektur und die logischen

Schaltkreise gebracht hatte.

Dr. Fey war ein Wissenschaftler von Weitblick und „großem Integral" (wie man profundes

Breitenwissen nennt) und in diesem Sinne aufmerksamer Leser internationaler Fachliteratur,

die in der Bibliothek des INT gut sortiert vorhanden war. Er hatte natürlich verfolgt, dass

PCM-Geräte mit 24 Kanälen um 1965 in den USA in Ortsnetzen eingesetzt wurden. Es gab

da natürlich einen Stilbruch, da beim Übergang vom digitalen Kanal zur analogen

Vermittlung immer Analog- Digitalumsetzer eingesetzt werden mussten. Erste Stimmen aus

den USA plädierten für den Aufbau digitaler Vermittlungen, mit denen man ein IDN

(Integriertes Digitales Nachrichtensystem) aufbauen müsse.

Dr. Fey war von der Idee fasziniert und reichte das Thema IDN als Staatsplanthema ein.

Aufgrund fehlender Wirtschaftskraft der DDR wurde das Thema wieder fallengelassen.

Ein PCM-Gerät für 32 Kanäle wurde jedoch entwickelt.

Der Autor hatte die Gelegenheit, an der Vorstellung eines im Institut für Nachrichtentechnik

entwickelten PCM 32 vor Repräsentanten der Deutschen Post (Ost) teilzunehmen. Die

Vertreter der Fernmeldehoheit sahen angesichts der im praktischen Einsatz gut

funktionierenden Trägerfrequenzgeräte keinen Bedarf an digitaler Technik.

Diese Ansicht änderte sich allerdings, als sich herausstellte, dass mit PCM-Technik der

dringende Bedarf an Stromwegen gedeckt werden konnte. Denn die im Ortskabelnetz noch

aus Kaisers Zeiten vorhandenen 4-Draht-Kupferleitungen waren alle zwei Kilometer mit

einem Spulenkasten ausgerüstet, der sich gut für die Unterbringung eines Repeaters eignete,

der die verflachten PCM-Impulse wieder auffrischte. Damit konnten beim Einsatz von PCM

auf diesen Kanälen 30 Verbindungswege geschaltet werden.

Das im INT entwickelte PCM-Gerät wurde in der NES erfolgreich beim Einsatz auf

schwerem Feldkabel erprobt.

Aus der Bibliothek des INT konnte ich mir ebenfalls westliche Fachliteratur ausleihen. Im

MfNV bekam ich diese Zeitschriften nur in der VS-Stelle und durfte sie nicht mit nach Hause

Die ersten Aufgaben zur Erprobung von Datenübertragungsgeräten über Drahtnachrichten

und Funkkanälen ließen neue Fragen entstehen, für die es im Rahmen der bisherigen

Aufgaben keine Antworten gab. Dieses neue Aufgabengebiet war dem Umstand geschuldet,

dass die militärische Führung ihre Befehle und Meldungen nicht mehr allein telefonisch über

Funk und Draht oder durch Fernschreiben übermittelte, sondern über Modem in Form von

Es gelang mir, neben den Unterabteilungen Funk- und Draht-Nachrichtentechnik, die sich

vor allem mit der Erprobung von Technik aus DDR-Produktion in Bezug auf ihre

Verwendbarkeit in der NVA beschäftigt, eine selbständige Arbeitsgruppe Datenübertragung

im Stellenplan zu installieren.

Ein Mitarbeiter dieser Arbeitsgruppe war

Oberleutnant Claus Wilhelm, Fernstudent an der

TH Dresden, ein Offizier der über schöpferische

Phantasie und Durchsetzungsvermögen verfügte.

Zur Besetzung von Zivilplanstellen hatten wir

Absolventen der TH Dresden geworben. Einer

davon ein ruhiger, kreativer Diplom-Ingenieur war

Eberhard Johlig, den ich auch in der AG DFÜ

Oltn. Wilhelm wollte sich nicht mit den

herkömmlichen Methoden der Erprobung

begnügen, d.h. Anschließen der Geräte und

versuchen die Ergebnisse zu deuten. Er schlug vor,

eine Messeinrichtung zu bauen, die

Fehlerstrukturen auf den von uns genutzten

Nachrichtenkanälen misst. Die Idee zum Bau eines

Messplatzes entstand, den wir SUSI (Gerät zur

Struktur Untersuchung Statistischer Impulsfolgen)

nannten. Nach Bewilligung der erforderlichen

Mittel schickte Oltn. Wilhelm den Dipl.-Ing. Johlig

zum Büromaschinenwerk Karl Marx Stadt und es

entstand der erste Messplatz dieser Art in

Deutschland. Die SUSI wurde Anfang 1968 in

Betrieb genommen (Bild 22). Der Sinn dieser

Messeinrichtung bestand darin, die Fehler nicht nur

zu zählen, sondern ihre genaue zeitliche Lage bei

der Übertragung einer

Bild 24: Messplatz SUSI

Bild 25: Längengewichtsverteilung der Fehler auf einem UKW-Kanal bei Übertragung

von Blöcken der Länge n=1, Gesamtzahl der Fehler 8386

Nachricht zu registrieren. Damit konnte nicht nur die Menge der Fehler in der Zeiteinheit

registriert werden, sondern auch die Fehlermuster.

Aus Bild 25 ist zu erkennen, dass 5856 übertragene Datenblöcke einen Fehler aufwiesen. In

970 Blöcken traten Doppelfehler auf, in 186 Blöcken traten zwei Fehler in einem Abstand

von einem ungestörten Bit auf usw.

Eine ausführliche Beschreibung der Messergebnisse und deren Anwendung ist in dem Buch

„Daten-Übertragung, Militärverlag der DDR, 1976. Herausgegeben von Claus Wilhelm"

Die gemessenen Daten waren eine Fundgrube. Ihre Auswertung sowohl auf unserem C8206,

auf der Minsk 22 im Institut für die Automatisierung der Truppenführung (IAT) in Dresden

sowie ab Anfang der 70er Jahre auf der BESM-6 des Instituts für Hochenergiephysik in

Zeuthen. Sie gestattete neue Einsichten in die Physik der Nachrichtenkanäle.

Eine weitere Verstärkung erhielt die Arbeitsgruppe Datenübertragung durch einen

als Offizier eingestellten Absolventen der TH. Dresden, Ltn. Dipl.Ing. Peter Uhlmann.

Hauptmann Wilhelm und Oltn Uhlmann verbrachten manche Nacht auf der Luftmatratze

hinter der Minsk 22 und überwachten die Berechnung von Übertragungsprozeduren und

Die Messergebnisse gestatten es sowohl optimale Prozeduren zur Datenübertragung

auszuarbeiten, als auch geeignete Codierverfahren zur Fehlersicherung zu bestimmen.

Auch zivilen Institutionen konnten wir helfen. Ein Mitarbeiter des Instituts für Post und

Fernmeldewesen Dipl. Trömel hatte die Fehlerstruktur bei Datenübertragung über Kanäle des

Selbstwählfernverkehrs auf Lochstreifen gespeichert. Über unsere Auswerte-Methoden

konnten wir eine mittlere Fehlerrate von 10-3 ermitteln.

Mit diesen Arbeiten rückt die NES in die vordere Reihe der Institute der DDR, die sich mit

Datenfernübertragung beschäftigen.

8. Hintergrund ab 1970

8.1 Der Mikroprozessor

Die Firma Intel war 1968 von Gordon E. Moore, Andy Grove und Robert Noyce (vergl. Pkt. 4) gegründet worden. Moore hatte 1965 das sog. Moorsche Gesetz formuliert, das aussagt, dass sich die Komplexität integrierter Schaltkreise mit minimalen Komponenten-Kosten etwa alle zwei Jahre verdoppelt.

Die damals kleine Firma Intel erhielt von dem japanischen Unternehmen Busicom 1969 den Auftrag für eine programmierbare Rechenmaschine einen Chipsatz von zwölf Halbleiterbausteinen zu entwickeln. Mit dem Auftrag wurde Tedd Hoff betraut. Hoff hatte die Idee den Auftrag mit einer Mehrzweckarchitektur zu erfüllen. Er hatte mit einem DEC-Computer gearbeitet und war begeistert, wie dieser Computer mit einem sehr einfachen Befehlssatz komplexe Probleme bewältigt. Folglich wollte er so etwas wie einen Computer auf einem Halbleiterchip nachempfinden.

Zu Hoffs Entwurfsteam gehörten damals Stan Mazor und Frederico Faggin, die letztlich im Konzept einen Satz aus vier Chips vorlegten: Einen ROM-Chip (den Intel 4001), ein RAM

für die Speicherung der jeweils errechneten Daten (den Intel 4002), ein Schieberegister für Eingang und Ausgang (den 4003) und letztlich die Prozessor Einheit, die CPU (den 4004). Diese 4004 CPU war der erste in Serie gebaute Mikroprozessor. Er hatte eine Taktfrequenz von bis zu 740 kHz.

Realisiert hat das Design dann in nur neun Monaten Frederico Faggin.

Nach einigen ökonomischen Querelen mit dem Auftraggeber Busicom, verkaufte Intel den Chipsatz billiger, behielt aber dafür die Rechte an der Erfindung des Mikroprozessors.

Der 4004 wurde 1972 durch den 8008 abgelöst, den ersten 8-Bit-Mikroprozessor der Welt. Dieser Prozessor war der Vorläufer für den äußerst erfolgreichen Intel 8080 (1974) und weiterer 8-Bit-Prozessoren von Intel. Der Motorola 6800 stand ab August 1974 im selben Jahr wie der 8080 zur Verfügung.

Faggin verließ nach vier Jahren das Unternehmen Intel und war Mitbegründer vo wo 1976 mit dem Z80 einer der wichtigsten 8-Bit-Mikroprozessoren entstand.

Der Krieg in Vietnam trat in die letzte Phase ein. Die Amerikaner, die ab 1965 in die Kämpfe zwischen Nord- und Süd- Vietnam eintraten, bauten zur Gewährleistung der militärischen Führung ein leistungsfähiges Fernmeldesystem auf. Da ein stationäres Nachrichtennetz nur in sehr eingeschränktem Maße zur Verfügung stand entfalteten amerikanische Firmen ein Netz aus Troposphären-Nachrichten-Verbindungen.

Die Truppen verfügten über die modernsten Nachrichten-Geräte, die hierbei im Einsatz erprobt wurden. Die geleisteten Anstrengungen wurden ausführlich in der der Fachpresse, u.a. in der Zeitschrift Elektronics beschrieben. So z.B. wurde über die in der Hauptnachrichtenzentrale in Saigon eingerichtete Rechnergestützte Fernschreibzentrale(Autodyn) berichtet.

Bis zum März 1975 wurden die Amerikanischen Truppen wieder abgezogen.

Die meisten Waffen, unter anderem die gesamte Fernmeldetechnik wurde der Südvietnamesischen Armee übergeben. Der Krieg endete mit der Einnahme von Saigon am 30. April 1975. Die Technik war Kriegsbeute der Vietnamesischen Volksarmee. Während der Kampfhandlungen wurden Rangereinheiten der Nordvietnamesischen Truppen eingesetzt, die Technische Zentralen sowie Brücken und andere strategisch wichtigen Objekte vor der Zerstörung zu sichern hatten.

8.3 Das Arpanet

8.3.1 Fortsetzung des Aufbaus

Im Verlaufe der 70er Jahre wurde das ARPANET immer weiter über das Territorium der USA gezogen. Es wurden successive die Werkzeuge und Methoden gefunden, die gegenwärtig bei Betrieb und Führung des Internets angewendet werden. Der Daten-Durchsatz der Verbindungsleitungen betrug 50 Kilobit. Für die damalige Zeit war das viel, für heutige Verhältnisse wenig, denn im ISDN werden 64 Kilobit auf einer Teilnehmer-anschlussleitung übertragen. Die Einbeziehung von Bolt und Beranek in das Netz mit dem IMP Nummer 5 gestattete die Fernwartung und Diagnose im gesamten Netz. Es entstand das erste Network Control Center (NCC).

Bis jetzt war das Netz nur ein (Groß-)Rechnerverbund. Nun entstand der Wunsch sich auch mit einem Terminal an das Netz anzuschließen und so sich auf einem fernen Rechner einzuloggen. Die nächsten IMPs erhielten eine Erweiterung. Neben den 4 Host-Schnittstellen erhielten sie 63 Schnittstellen zur Bedienung von Terminals. Ein solcher Terminal-IMP wurde TIP genannt.

Ab Mitte 1971 gab es eine Network Working Group, die Protokolle entwickelte mit Hilfe deren Rechner und Terminals unterschiedlichster Hersteller miteinander kommunizieren konnten. Das erste Protokoll war das Telnet Protokoll. Damit war es möglich sich mit einem fernen Rechner zu verbinden.

Im Jahre 1972 wurde das File Transfer Protokoll FTP vorgestellt, mit dem man Dateien (Files) von einem Rechner zum anderen übertragen konnte. Die Protokolle wurden den Nutzern in sog. RFCʻs (Requests For Comment ) vorgestellt. Das war eine Einladung seine Gedanken zum Protokoll mitzuteilen. FTP war in der RFC 354 spezifiziert, Telnet in der RFC 318. Beide Protokolle wurden ständig weiterentwickelt und werden heute noch benutzt. Im Jahre 1972 wurde die ARPA in DARPA (Defense Advanced Research Projects Agency)umbenannt. Der Name ARPANET änderte sich dadurch nicht.

Ein Programm, das man als meistbenutztes Programm des Internets bezeichnen kann, ist E-Mail, die elektronische Post. Ray Tomlinson schrieb 1972 das Email-Programm mit dem @ als Trennzeichen zwischen Name und Adresse. Leider sind 90 % der E-Mails heute unerwünscht, also Spam, ähnlich der Werbungen die unsere Briefkästen überfluten.

Im Herbst 1972 wurden die bis dato installierten 29 Knoten bei einer großen Präsentation, erstmals als ARPANET bezeichnet. Das bis 1974 genutzte Protokoll, das die Kommunikation der Rechner mit den IMPʻs regelt, hieß Network Control Protocol (NCP). Das NCP setzte voraus, dass die Verbindungen des Netzes 100 % zuverlässig waren. Da dies nicht der Fall war, entwickelten Cerf und Kahn ein Konzept, bei dem die Nachrichten in Datagramme eingeschlossen und nur am Ende der Verbindung ausgepackt werden. Die Datagramme waren mit einem Protokollkopf versehen, dem Transmission Control Protocol (TCP) Kopf, mit dem die Unversehrtheit der Nachricht festgestellt werden konnte. Damit wurde das Problem der Netzwerk-Zuverlässigkeit gelöst. Die Sicherung der Zuverlässigkeit wurde vom Netz auf die Hosts verlagert.

Im Oktober 1977 gelang es, die drei Netzwerke Packet Radio Netzwerk, ARPANET und SATNET zu koppeln.

8.3.2 Das IP-Protokoll

Anfang 1978 fand am Information Sciences Institute (ISI) eine Beratung zum Thema TCP statt. Im Rahmen dieser Veranstaltung schlugen Cerf, Postel und Cohen vor, vom TCP den Teil des Übertragungs-Steuerungsprotokolls für das Routing abzutrennen und dafür ein eigenes Protokoll, das Internet-Protokoll IP zu entwickeln. Am Anfang der zuübertragenden Nachricht stand nun nicht mehr der TCP, sondern der IP Kopf.

Im unteren Teil von Bild 24 ist ein Paket mit einem IP-Header aufgezeichnet. Die Struktur dieses Header ist im oberen Teil des Bildes dargestellt. Da das IP-Protokoll in der gesamten Netzwerktechnik eine Schlüsselrolle spielt, soll der Inhalt der einzelnen Felder des Kopfes kurz erklärt werden:

Bild 26: Aufbau des IP-Kopfes und eines IP Rahmens

- Die Versionsnummer ist allgemein 4 (IPV4). Die Version 6 ist in der Einführung

- Die Länge des Kopfes wird in 32 Bit Worten angegeben. Sie beträgt (ohne das

Optionenfeld) normalerweise 5.

- Servicetypen sind Priorität, Wartezeit, Durchsatz und Zuverlässigkeit. Da im Internet

allgemein nicht Wege verschiedener Qualität zur Verfügung stehen, wird von diesen

Klassen dort allgemein kein Gebrauch gemacht.

- Die Paketlänge stellt die Gesamtlänge des Paketes einschließlich Protokollkopf dar. Die

maximal mögliche Länge eines IP-Paketes beträgt 216 = 65535 Bytes.

- Die Identifikation ist eine Zahl, die pro Paket vom Absender vergeben wird und auch zur

Identifizierung der Fragmente beim Aufteilen eines Paketes in kürzere Teilstücke dient.

- DF heißt Donʼt Fragment und stellt das Verbot der Teilung des Paketes in Fragmente dar

Vergleiche auch Bild 25.

- MF heißt More Fragments und zeigt an, dass dem Paket weitere Teilpakete folgen. Der

Fragmentabstand enthält die Lage des Teilpaketes relativ zum Kopf (gezählt in Einheiten zu 8 Byte)

- Die Lebenszeit gibt an, wie viele Router (Netzknoten) das Paket durchlaufen darf

(Häufig 64). Beim Durchlauf durch einen Router wird die Lebenszeit (TTL = Time To Live) um 1 verringert. Wenn ein Router das letzte Bit Lebenszeit löscht, schickt er dem Absender eine Information, dass das Paket aus dem Verkehr gezogen wurde. Dadurch wird verhindert, dass Pakete durch das Netz vagabundieren (herumirren).

- Im Feld Transportprotokoll wird angegeben, welchem Protokoll der Paketinhalt

übergeben werden muss. Z.B. steht die Nummer 6 für TCP (Transport Control Protocol) und die Nummer 17 steht für UDP (User Datagram Protocol).

- Die Kopfprüfsumme sichert nur die Felder im Protokollkopf. Der zu transportierende

Paketinhalt wird beim Empfänger durch das Transportprotokoll geprüft.

- Sender- und Empfängeradresse sind 32 Bit lange Internetadressen (siehe Bild 26).

- Optionen sind Angaben für spezielle Zwecke, wie z.B. Netzwerkmanagement usw.

- Füllzeichen dienen der Ergänzung dieser Zeile auf 32 Bit.

Bild 27: Fragmentierung von IP-Paketen

Bild 28: Einteilung der Internetadressen

IP-Adressen und Domainnamen (auf letztere wird in diesem Zusammenhang nicht eingegangen ) werden durch sog. Network Information Center (NIC) vergeben. Die Firma Network Solutions betreibt als oberste Instanz für das Internet das InterNIC. Von diesem werden die Aufgaben delegiert. Für die Top-Level-Domain *.de (Deutschland) an das DE-NIC.

Außer den Klassen A,B,C gibt es noch das reservierte!

Klasse-D-Netz von 224.0.0.0 bis 239.255.255.255 und das reservierte

Klasse-E-Netz von 240.0.0.0 bis 254.255.255.255.

Die Adressen 127.x.x.x sind für den Loopback reserviert. Z.B. ist 127.0.0.1 die Adresse des Localhosts. Für den „Hausgebrauch" wurden laut RFC 1918 folgende private Adressbereiche definiert:

1 privates Klasse-A-Netz (10.0.0.0 bis 10.255.255.255),

16 private Klasse-B-Netze (172.16.0.0 bis 172.31.255.255

256 private Klasse-C-Netze (192.168.0.0 bis 192.168.255.255).

Da IP-Pakete über sehr unterschiedliche Netzwerktypen transportiert werden müssen, muss IP in der Lage sein, die Paketgröße der Datagramme an die Eigenschaften der verschiedenen Übertragungsabschnitte anzupassen. Pakete nach CCITT-X25 dürfen z.B. nicht länger als 128 Byte sein. Für Ethernetpakete ist dagegen eine Länge des Datenpaketes von 1526 Byte zulässig. Daher muss das IP-Protokoll in der Lage sein, in jedem Netzknoten die Paketgröße an das jeweils zu benutzende Trägermedium anzupassen. Das bedeutet, dass die Möglichkeit besteht, im Netzknoten Pakete sowohl zu fragmentieren als auch wieder zusammenzusetzen (defragmentieren ).

8.3.3 Das Transport Control Protocol

Die Zustellung der Pakete im Internetprotokoll erfolgt „best effort". Dass Pakete nicht ankommen, muss von dem die Daten sichernden Protokoll bemerkt werden. Die Daten werden durch das Transmission Control Protocol TCP gesichert.

29: Der TCP Protokollkopf

Der TCP-Kopf ist in Bild 29 dargestellt. Die wichtigste Einträge im TCP-Protokollkopf sind:

- Die 16 Bit lange Prüfsumme erstreckt sich über den Protokollkopf und die zu transportierenden Daten.

- Beim Verbindungsaufbau tauschen die Partner jeweils eine 32 Bit lange Sequenz- Nummer (Sender an Empfänger) und eine Quittungsnummer (Empfänger an Sender) aus. Bei der Übertragung übergibt der Sender die um die Zahl der gesendeten Bytes

erhöhte Sequenznummer an den Empfänger, der Empfänger quittiert mit der um die Zahl der empfangenen Bytes erhöhten Quittungsnummer.

- Ein wichtiges Element in der Adressierung auf der Transportebene sind die Portnummern. Von den 216 = 65536 möglichen Portnummern sind einige hundert für die bekannten Dienste fest vergeben. Z.B. besitzt der Internetzugang die tcp-Portnummer 80. Einem Filetransferprotokoll (ftp) Server ist die tcp-Portnummer 21 für den Austausch von Steuerungsinformationen und die tcp-Portnummer 20 für den Datenaustausch zugeordnet. Einen Telnet-Server erreicht man über die tcp-Portnummer 23. Man unterscheidet tcp- Portnummern und User Datagram Protokoll (udp) Portnummern.

Wenn eine tcp/ip Verbindung aufgebaut werden soll, dann muss sowohl die IP-Nummer des Empfängers (Netz und Host-ID) bekannt sein, als auch der Dienst, repräsentiert durch seinen Port an dem die Pakete abzuliefern sind. Damit der Gerufene bzw. Belieferte antworten kann, wählt er aus der Menge der unbenutzten Portnummer (allgemein Werte über 2000) eine aus und gibt sie als Empfänger Port an.

Die Kombination aus kompletter IP Nummer und Portnummer nennt man auch einen Kommunikationsendpunkt oder Socket.

- Der Datenabstand DA gibt die Länge des TCP-Protokollkopf in 32-Bit-Worten an.

- Die Fenstergröße dient der Steuerung des Datenflusses, sie enthält die Anzahl von Bytes, die der Empfänger im Moment puffern kann.

- Es werden die folgenden Flags verwendet: U=Urgent (Dringend), zeigt an, dass der Zeiger im Urgent- Feld gültig ist. A=ACK zeigt an, dass die Quittungsnummer gültig ist. P=Push heißt, die Daten sollen sofort übergeben werden. R=RST heißt Rücksetzen der Verbindung oder ungültiges Element. S=SYN stellt den Wunsch nach Verbindungsaufbau dar. F=FIN stellt den Wunsch nach Verbindungsabbau dar. Die beiden letztgenannten Flags müssen von der Gegenstelle quittiert werden.

- Der Urgentzeiger weist auf das letzte Byte der zu übertragenden Nachricht. Die darauf folgende Information sind dringende Systemnachrichten.

8.4 ALOHAnet

Bei Wikipedia liest man folgendes:Wie das ARPANET wurde das ALOHAnet mit Mitteln der DARPA finanziert. Aber während das ARPANET gemietete Telefonleitungen verwendete, nutzte das ALOHAnet Packet Radio. Beim ARPANET konnte ein Knoten mit mehreren anderen Knoten über Leitungen kommunizieren, während beim ALOHAnet alle dieselbe Funkfrequenz nutzten, womit es notwendig wurde, Kollisionen auf diesem Kommunikationsmedium zu erkennen und zu behandeln.

Beim ALOHAnet wurden zwei Funkkanäle verwendet: ein Broadcast-Kanal (413.475 MHz) und ein Random-Access-Kanal (407.350 MHz). Auf letzterem sendeten die einzelnen Stationen ihre Datenpakete zum Zentralrechner. Dieser bestätigte den Empfang jedes Pakets auf dem Broadcast-Kanal. Versuchten zwei Stationen zugleich zu senden, kam keine der beiden Nachrichten richtig an. Der Zentralrechner sendete keine Bestätigung, und die Sender versuchten es unabhängig voneinander nach einer zufällig gewählten Zeitspanne erneut. Die Chancen, dass beide Sender beim nächsten Übertragungsversuch wieder eine Kollision erzeugten, wurden so minimiert.

8.5 Ethernet

Im Jahre 1972 las Robert Metcalf Aufzeichnungen von Professor Abramson über das ALOHAnet und entdeckte darin Ungenauigkeiten im Prozessablauf. Er fuhr nach Hawaii und schlug vor, die Teilnehmer nicht blind ihre Pakete auf dem Radom-Access-Kanal abzusetzen, sondern vorher in den Kanal hineinzuhorchen, ob er frei ist. Mit dieser Verbesserung arbeitete das ALOHAnet effektiver.

Metcalf erhielt danach von der Firma XEROX, dem Palo Alto Research Center (PARC), den Auftrag für den neu entwickelten Personalcomputer ALTO eine Vernetzungs-Möglichkeit mit anderen Computern zu entwickeln. Da er aus Kostengründen keine Vermittlung oder Ähnliches verwenden wollte, entschied er sich für eine ALOHA-ähnliche Konstruktion. Anstelle des Funknetzes verwendete er ein Koaxialkabel. Die Rechner sind dabei alle direkt mit einem Kabel fest verdrahtet. Ein Rechner, der ein Datenpaket verschicken will, horcht in den Kanal hinein (Carrier Sense) ob er frei ist. Wenn ja sendet er sein Datenpaket. Sollte ein anderer Teilnehmer das Gleiche tun, gibt es eine Kollision, die der Sender registriert (Collision Detection). Der Sender wartet nun ein paar Tausendstel Sekunden (zufällige Verzögerung) und wiederholt den Vorgang. Metcalf taufte das System 1973 Ethernet. Im ETHERNET wird eine zu übertragende Nachricht in Abschnitte (Pakete) zerlegt, die beim Transport über das Ethernet bis 1500 Byte lang sein dürfen.! Die Pakete werden in einen Rahmen eingefügt, der Ziel und Absender eines Paketes und Informationen zu dessen Sicherung enthält. Der Aufbau eines Paketes ist in Bild 30 dargestellt:

Bild 30: Aufbau eines ETHERNET_802.3, bzw. ETHERNET_II Rahmens

Die Präambel besteht aus 7 mal 10101010-Bit Kombinationen zur Synchronisation desEmpfängers und einer Bitkombination 10101011 zur Signalisation des Rahmenanfangs.

Ziel- und Quell- Adresse sind 6 Byte lange Hexadezimalzahlen, wobei die Quelladressen auf einem Chip der Ethernetkarte eingebrannt und weltweit einmalig sind. Die ersten drei Byte dieser Adresse nennen den Hersteller, die restlichen drei Byte die laufende Nummer der Karte.

Aufgrund ihrer Einmaligkeit wurde die 6-stellige Hexadezimalzahl bei Novell ursprünglich als Adresse der Arbeitsstation bzw. des Servers benutzt, in dem die dazugehörige Ethernetkarte steckt.

Beim alten Netware stand in dem 2 Byte langen Feld nach der Quelladresse die Länge des Datenfeldes. Ein Rahmen dieses Aufbaus ist vom Typ ETHERNET_802.3. Über die Art der Daten bzw. über das verwendete Protokoll wird dabei nichts ausgesagt.

Im von XEROX vorgeschlagenen Rahmenaufbau folgt der Quelladresse ein 2 Byte langesTypfeld. Im Typfeld wird das Protokoll spezifiziert, mit dem die Daten transportiert werden.

In diesem Fall haben wir es mit einem Rahmen vom Typ ETHERNET_II zu tun.

Eine Unterscheidung beider Rahmen ist leicht, da die maximale Länge des Datenfeldesvon 1500 Byte einer Länge von OxO5DC hexadezimal entspricht. Die Liste der Protokoll -

Typen wird von der Firma XEROX verwaltet und beginnt dagegen bei 0x0600. Aus der Liste der über 200 Protokolle seien hier nur drei genannt (Bild 29). Das Internetprotokoll wurde oben bereits erklärt. Das von Novell erfundene Protokoll IPX wird nur noch in alten Anlagen verwendet.

Bild 31: Ausgewählte Protokolltypen

Das ARP soll im nächsten Abschnitt kurz beschrieben werden, da es Grundlage für die Verbindung des Internets mit den lokalen Computernetzwerken bildet.

8.6 Das Adress Resolution Protocol

Nachdem im Internet (Fernnetz) die IP-Adressen eingeführt worden waren, bestand die Notwendigkeit auch in lokalen Netzen mit dem Internetprotokoll zu operieren. Dazu musste eine Methode gefunden werden, die den Rechnern zugeordnete IP-Adresse mit der 6 Byte langen Hardwareadresse in Beziehung zu setzen.

Das zugrunde liegende Protokoll heißt Adress Resolution Protocol ARP. Es funktioniert folgendermaßen:

1. Jeder Rechner verfügt über eine temporäre Tabelle in der die im (Lokalen) Netz bekannten Rechner mit ihrer Physikalischen und ihrer Internet Adresse aufgeführt sind. Z.B.

!

Soll ein Datenpaket an die Internet-Adresse 192.168.178.23 gesendet werden, muss die dem Rechner zugeordnete Hardware-Adresse in das in Bild 28 dargestellte Paket eingesetzt und über das Ethernet verschickt werden. Nach einer Zeit (bis 20 Minuten) wird die Tabelle gelöscht und muss bei Bedarf neu aufgebaut werden. Das geschieht wie folgt:2. Es wird ein ARP-Broadcast-Paket mit der Internet-Adresse des gesuchten Rechners

und der Absender-Hardware-Adresse gebildet und ins Netz gesendet.

3. Alle Rechner im Netz erhalten das ARP-Paket und vergleichen die darin enthaltenen

Internet-Adresse mit ihrer eigenen. Der gesuchte Rechner trägt seine Hardware-Adresse in ein Antwortpaket ein und sendet es zurück.

4. Die oben genannte Tabelle kann nun wieder aufgebaut werden.

8.7 Der erste Personalcomputer war ein Apple

Im Jahre 1975 war Steve Wozniak 26 Jahre alt und bei Hewlett Packard angestellt. Er wollte einen billigen Rechner für Computerinteressenten bauen. Die Chiphersteller Intel

und Motorola verkauften ihre

Prozessoren für über 300 $. Die kleine Firma MOS Industries verkaufte den zum Motorola 6800 Hardwarekompatiblen 6802 für 25 $. Wozniak rüstete daher seinen PC mit diesem Schaltkreis aus.

Wozniaks Computer sollte einfach zu benutzen sein, daher entschied er sich für

eine richtige Tastatur statt

Bild 32: a) Steve Wozniak!

der bis dahin üblichen Schalter. Außerdem sollte der Rechner direkt an ein Fernsehgerät anschließbar sein um die Kommunikation für den Nutzer zu vereinfachen (andere Geräte benutzen zu dieser Zeit noch Fernschreiber für die Ein- und Ausgabe).

Steven Wozniak und Steven Jobs waren schon in der High School befreundet. Beide interessierten sich für Elektronik und galten als Außenseiter. Nach ihrem Abschluss arbeitete Jobs bei Atari. Im Jahre 1975 löteten sich Steven Wozniak und Steven Jobs in Jobs' Garage einen eigenen Computer zusammen, den Apple I. Insgesamt benötigten sie dafür nur ca. 60 Arbeitsstunden. Der verwendete Prozessor 6502, war leistungsfähiger als der Intel 8080. Steven Jobs und Steve Wozniak gründeten am 1. April 1976 die Firma Apple. Jobs war zu diesem Zeitpunkt 21, Wozniak 26 Jahre alt.

8.8 Die Gründung von Microsoft

Bill Gates programmierte bereits auf der Highschool auf ihm zur Verfügung stehenden

Rechnern. Er adaptierte unter anderem BASIC - eine leicht erlernbare Sprache - für die auf- kommenden Mikro-Prozessoren. Als 1975 der Altair 8800 erschien, sahen er und sein Freund Paul Allen die Chance, die schon begonnene Arbeit zu Geld zu machen. Innerhalb von 30 Tagen adaptierten sie BASIC für den Altair 8800. Die Microsoft Corporation wurde 1975 von Bill Gatesund Paul Allen gegründet.

Bild 33: Steve Jobs (links) und Bill Gates (rechts) waren befreundet.

Der Name „Microsoft" steht für Mikrocomputer-Software. Am 6. Januar 1976 wurde „Microsoft" eine eingetragene Handelsmarke. Die Firma veröffentlichte Adaptionen von FORTRAN und COBOL-80. Es gab einen BASIC Compiler, Disketten- BASIC für verschiedene MikroprozessorenMicrosoft entwickelte eine Z80 Karte für den Apple. Zusammen mit dem Betriebssystem CP/M konnte damit ein Apple auch Microsoft Programmiersprachen verarbeiten,

9. Vordergrund ab 70

9.1 Der Lehrstuhl Informationstechnik der TH Karl-Marx-Stadt.

Der Direktor des Instituts für Nachrichtentechnik Dr.-sc.-techn. Peter Fey nahm Ende der

sechziger Jahre eine Berufung als Professor und Leiter der Sektion Informationstechnik an der

TH Karl-Marx-Stadt an. Er scharte dort alsbald eine Gruppe ambitionierter und kreativer

Assistenten und Studenten um sich.

Professor Fey war auch im Ausland renommiert und wurde regelmäßig zu Tagungen und

Studienaufenthalten eingeladen. Vom Besuch des Zürich-Seminars brachte er 1976

Dokumentationen des i8008 und einen Satz Schaltkreise mit.

Die vom ihm verbreitete Vision, dass in Zukunft Nachrichtengeräte mit einem Prozessor

ausgestattet werden können, faszinierte mich.

Ich delegierte einen Mitarbeiter meiner Dienststelle an den Lehrstuhl von Prof. Fey, der dort

an einem Cross Compiler das Programmieren des i8008 erlernen sollte.

Zur Förderung der Softwareentwicklung wurden einige Software-Entwicklungssysteme ZDS-2

von ZILOG in ausgewählten Einrichtungen der DDR eingeführt. In den meisten

Einrichtungen verschwanden diese Systeme hinter verschlossenen Türen und waren nur

einem kleinen Kreis von Ingenieuren zugänglich.

Im Gegensatz dazu war in der Sektion Informationstechnik der Technischen Hochschule Karl-

Marx-Stadt das ZDS-2 öffentlich im Praktikum aufgebaut und stand rund um die Uhr den

Studenten zum Praktikum zur Verfügung.

Das ZDS-2 war mit dem Betriebssystem RIO ausgerüstet. Wer RIO und UNIX kennt, kommt

zu der Schlussfolgerung, dass die RIO-Entwickler UNIX-Kenner waren. Dafür sprechen das

Filesystem, der Kommandointerpreter, die Anwendung logischer Geräte, die Modularität von

Gerätetreibern und Kommandos usw. Der RIO-Editor edit zeigt starke Verwandtschaft zum

UNIX-Editor ed und das Textformatierungsprogramm Uform zeigt Ähnlichkeiten zu nroff.

Am 1. September 1970 wurde ich vom Rektor der TH Karl-Marx-Stadt in die

außerplanmäßige Aspirantur aufgenommen. Das Thema lautete: „Die Codierung von

Nachrichten zum Zwecke der Fehlererkennung bei der Übertragung über reale

Nachrichtenkanäle".

9.2 Erste Lagedarstellung mit Hilfe von Mikrorechnern

Unser Programmierer für den i8008 Diplom Ingenieur Troppenz erhielt nach seiner

Ausbildung in Karl Marx Stadt die Gelegenheit, am K2-Muster des K1510 im Labor von

ROBOTRON in Dresden, ein einfaches Lagedarstellungsprogramm zu implementieren.

Im 4. Quartal 1978 fand in der Nähe von Niederlehme eine Nachrichtenübung statt. Es war

eine komplette Nachrichtenzentrale entfaltet einschließlich des P249 mit dem Lageanalyse

Moduls ARWU (vergl. Abschnitt 7.1).

Wir hatten eine vierdrähtige Fernschreibleitung bestellt. Diese verlief vom Übungsgelände

nach Dresden zu ROBOTRON, wo die Leitung vom Schaltkasten auf dem Hof durch das

Fenster des Labors im 1. Stock geführt war. Die Senderichtung spielte die Lagedaten des

ARWU in das K2-Muster des K1510. Die Empfangsrichtung übertrug das von Dipl.-Ing.

Troppenz programmierte Schema der Lagedarstellung in Echtzeit nach Niederlehme zurück

auf einen Empfangsfernschreiber F1200 (Nadeldrucker), der beim Chef Nachrichten (CN) der

Übung auf dem Tisch stand. Sehr zum Ärger des Leiters der Nachrichtenzentrale (LN) war der

CN stets eher von der aktuellen Lage informiert als der LN. Wir lösten das Problem, indem

der LN ebenfalls einen F1200 erhielt. Der Empfangsfernschreiber war übrigens nur deshalb

notwendig, weil uns zu dieser Zeit nur Bildschirme mit einer Auflösung von 8x16

Buchstaben zur Verfügung standen.

9.3 Es geht weiter mit der Mikrorechner Ausrüstung

Die Führung der DDR erkannte die große Bedeutung der Mikroelektronik für die

Rationalisierung in der Volkswirtschaft. In einer Ausstellung aus Anlass des 6.Plenums des ZK

der SED zur Mikroelektronik wurde Regierungsmitgliedern nahegebracht welche

Möglichkeiten die Anwendung der Mikrorechentechnik der Volkswirtschaft bietet. Bei einer

nachträglichen Besichtigung der Ausstellung sah ich z.B., dass mehrere Zeitungsseiten

ausgebreitet waren um zu demonstrieren wie viel Information auf einen 64 KByte

Ich erfuhr, dass der Landwirtschaftsminister ihm bereits zugeteilte Valuta zum Import von

Zwiebeln zurückgegeben hat, um Reinstlacke und Chemikalien zur Herstellung von

Mikrochips zu importieren. Trotz nicht zu übersehender wirtschaftlicher Probleme der DDR

wurde der Einführung der Mikroelektronik viel Kraft gewidmet.

Als erster Mikroprozessor wurde in der DDR im Jahre 1979 der U 808 (Vorbildtyp i8008)

Der U880 (Vorbildtyp Z80) wurde 1980 in die Produktion überführt.

Ab 1978 wurde das Mikrorechnersystem K1510 vom Kombinat Robotron gefertigt.

Bild 34: a) Rechner K4201

b) PBT 4000 (Basis U808)

Meine Dienststelle bekam den ersten K1510 in Gestalt eines PBT 4000 im Jahre 1979

zusammen mit einem K 4201 (auch R4201), der eine umfangreichere Peripherie ansteuern

konnte. Vorteil des R4201 war, dass er außer als Prozessrechner auch als universeller

Rechner für wissenschaftlich-technische Berechnungen einsetzbar war.

Da Ausrüstungen für Rechentechnik einem strengen Embargo unterlagen, hatten für uns

technische Komponenten den gleichen Stellenwert wie Lebensmittel in der Kriegs- und

Floppy-Disk (8 Zoll) Laufwerke wurden im Sozialistischen Wirtschaftsgebiet in Ungarn

hergestellt. Im Ministerium für Nationale Verteidigung war die Verwaltung für

Automatisierung und Mechanisierung der Truppenführung (MAT) Bedarfsträger für

Rechentechnik. Mit den Mitarbeitern dieser Verwaltung pflegte ich eine gute, kamerad-

schaftliche Zusammenarbeit. Auf eine Bitte nach Lieferung eines Floppy-Disk Laufwerkes

erhielt ich ein Schreiben, das es mir gestattete beim Büromaschinenwerk Sömmerda,

ein solches Laufwerk abzuholen.

Aus Anlass eines Internationalen Wissenschaftlichen Kolloquiums im Jahre 1978 an der TH

Ilmenau machte ich mit Prof. Fey und Dr. Wilhelm einen Abstecher nach Sömmerda um das

mir zugeteilte Floppy-Disk Laufwerk abzuholen. Nach Erledigung der Formalitäten in der

Verwaltung des Werkes, fuhr ein Mitarbeiter mit dem Fahrrad uns im weitläufigen

Werksgelände voran zu einem Schuppen, in dem neben Malerbedarf auch Goldstaub in

Gestalt besagter Laufwerke lagerte.

Am Abend auf unserem Hotelzimmer besichtigten wir das Wunderding und versuchten die

aus der Literatur bekannten Komponenten praktisch zuzuordnen.

Bereits am nächsten Abend übergab Prof. Fey das Gerät an (damals noch) Dipl. Ing.

Burckhard mit dem Auftrag, zum Gerät eine Ansteuerung zu bauen.

Es war das gleiche Gerät für das Dipl.-Ing. Päßler zwei Jahre später die Ansteuerung des

ZDOS entwickelte. Das oben erwähnte ZDS 2 arbeitete mit hartsektorierten Disketten, d.h.

zur Unterscheidung der Sektoren der Floppy-Scheibe waren Löcher angebracht. Dieser

Umstand hinderte sowohl die Techniker von Robotron als des KEAW daran, das ZDS2

Matthias Päßler schrieb einen Treiber, zu dem ich ihm ein Polynom für die Fehler-Entdeckung

berechnete, sodass die Ansteuerung von softsektorierten Disketten der Robotron Computer

durch das ZDOS möglich war. Ich erinnere mich, dass mich der Entwickler Päßler nach einer

im Labor des Lehrstuhls Informationstechnik in Karl Marx Stadt durchgearbeiteten Nacht früh

um 7 Uhr in meinem Arbeitszimmer anrief und mitteilte: „.das ZDOS läuft softsektoriert."

9.4 Neue Dienststelle neue Aufgaben

Dem Chef Nachrichten im Ministerium für nationale Verteidigung unterstand außer der NES

auch noch die Aufbauleitung, eine Dienststelle, die den Aufbau eines integrierten

Fernmeldenetzes der Regierung und der bewaffneten Organe der DDR (Stabsnetz) führte.

Dieses Stabsnetz wurde auch Sondernetz 1 „S1" genannt. Da bei der Planung und

Realisierung des „S1" in zunehmendem Maße technisch wissenschaftlich Aspekte eine Rolle

spielten, entschloss sich der CN Generalmajor Reymann die NES und die Aufbauleitung zur

Zentralstelle für Nachrichtennetze zusammenzulegen. Außer dem vorhandenen

Personalbestand wurden der Einrichtung noch einige Stellen hinzugefügt. Mit der Führung

der ZFN wurde ich beauftragt.

Mein Stellvertreter für Planung und Investition war Oberst Meinung, ein ausgefuchster

Ökonom, Stellvertreter Wissenschaft und Technik wurde Oberst Dost.

Nicht als Stellvertreter aber mir direkt unterstellt war Major Dr.-Ing. Wilhelm als Leiter der

Unterabteilung Netzplanung, dem ich auch die Rechenstelle unterstellte.

Dr. Wilhelm hatte 1973 bei Prof. Wiegmann an der TH Dresden zum Thema Kanalmodelle

promoviert. Er war beim Aufbau des „S1" für den technisch theoretischen Teil verantwortlich.

Dem Stellvertreter Planung Investition unterstanden die Unterabteilung 1 (Planung und

Bilanzierung), Unterabteilung 2 (Investitionsvorbereitung) und die Unterabteilung 3

Dem Stellvertreter WT unterstanden die Unterabteilung 5 (verantwortlich für die Einführung

neue Technik aus der Sowjetunion) und die Unterabteilung 6 (Funk und

Drahtnachrichtentechnik aus DDR-Produktion).

Während ich auf die Zuführung von Offizieren in meine Dienststelle praktisch keinen

Einfluss hatte, gelang es mir bei der Einstellung von jungen Hochschulabsolventen einige

ausgezeichnete ideenreiche Mitarbeiter zu gewinnen, über die noch zu berichten sein wird.

Zur Gewährleistung der Führung des Sondernetzes 1 wurde die Zentralstelle für Schaltung

und Betrieb ZfSB geschaffen. Ihr unterstanden die Schalt- und Betriebszentralen, die an den

Standorten der Haupt- und Knotenämter entfaltet wurden. Die Vermittlungen waren vom Typ

ATZ 65. Die Fernsprechkanäle wurden mit Koordinatenschaltern durchgeschaltet.

Diese Technologie war „State of the Art", obwohl sich im westlichen Ausland bereits

elektronische Fernzentralen in Entwicklung befanden.

Wir versuchten den Rückstand teilweise dadurch wett zu machen, dass wir die Mess- und

Kontrolltechnik computergestützt planten. Das Personal für diese anspruchsvollen Aufgaben

warben wir an Hochschulen und Universitäten. Vom Lehrstuhl Professor Feys waren das die

Diplom Ingenieure Päßler und Richter. Eine der ersten Aufgaben für diese beiden jungen

Wissenschaftler bestand in der Entwicklung eines Farbdisplays auf der Grundlage eines

handelsüblichen Farbfernsehempfängers.

Im Mai 1975 erhielt ich vom CN die Aufgabe, mich darauf vorzubereiten, mit einer

Militärdelegation der NVA als Nachrichtenspezialist im Juli nach Vietnam zu fliegen.

Dass gerade die DDR von der im Vietnamkrieg siegreichen Volksrepublik zu einem Besuch

eingeladen wurde, hatte Gründe. Die Großen Verbündeten Vietnams, die Sowjetunion und

die VR China waren zerstritten, sodass man weder beide gemeinsam noch einen allein zu

einem Freundschaftsbesuch einladen konnte.

Die kleine DDR hingegen hatte viel ideelle und materielle Solidarität geübt und war auch bei

den beiden Großen gut angesehen.

Zur Vorbereitung des Besuchs ließ ich mir die relevanten amerikanischen Fachzeitschriften

kommen, insbesondere die ELEKTRONICS, in der umfangreiche Berichte über die

Anstrengungen amerikanischer Firmen zur Ausstattung des (Süd-) Vietnamesischen

Nachrichtensysteme verzeichnet waren.

Da die Berichte nicht mit Details sparten, konnte ich mir über die Technik, die wir ggf. zu

sehen bekamen, vorab ein sehr gutes Bild verschaffen. Die vietnamesischen Genossen waren

immer überrascht, wenn ich beim Besuch einer Nachrichtenzentrale meistens wusste,

welche Technik ich dort vorzufinden hoffte.

In diesem Bericht möchte ich von den zahlreichen Eindrücken und Erlebnissen nur zwei

Eine für mich sehr beeindruckende Nachrichtenzentrale war die auf dem Affenberg in

Da Nang. Sie war mit Troposphären Richtfunk Stationen ausgerüstet, die das Rückgrad der

Nachrichtenkanäle nach Süden und Westen bildeten. Da kein öffentliches Stromnetz

existierte, wurde die Stromversorgung durch Aggregate sichergestellt, deren Benzinverbrauch

durch Tankschiffe befriedigt wurde, die regelmäßig im Hafen anlegten.

Die Vietnamesen, die nicht soviel Treibstoff besaßen, konnten also die Aggregate nicht Tag

und Nacht durchlaufen lassen und waren dadurch nicht in der Lage, eine stabile

Nachrichtenverbindung zustande zu bringen.

Eine zweite Technik interessierte mich mehr. Das war die Rechnergestützte Fernschreib-

Zentrale in Saigon. Als wir den ersten Abend in Saigon von der Führung des Militärbezirks

zum Abendessen eingeladen waren, hatte ich mit den leitenden Nachrichten Offizieren sehr

freundschaftliche Gespräche. Nur einem Thema wichen sie aus. Sobald ich auf die Autodyn

Zentrale zu sprechen kam, verstanden sie plötzlich kein Wort mehr und versuchten das

Thema zu wechseln. Offenbar betrachteten sie dieses High-Tech System als selbst noch zu